다차원 프롬프트 체이닝을 통한 소형 언어 모델의 오픈‑도메인 대화 품질 향상

📝 원문 정보

- Title: Multi-Dimensional Prompt Chaining to Improve Open-Domain Dialogue Generation

- ArXiv ID: 2601.01037

- 발행일: 2026-01-03

- 저자: Livia Leong Hui Teng

📝 초록 (Abstract)

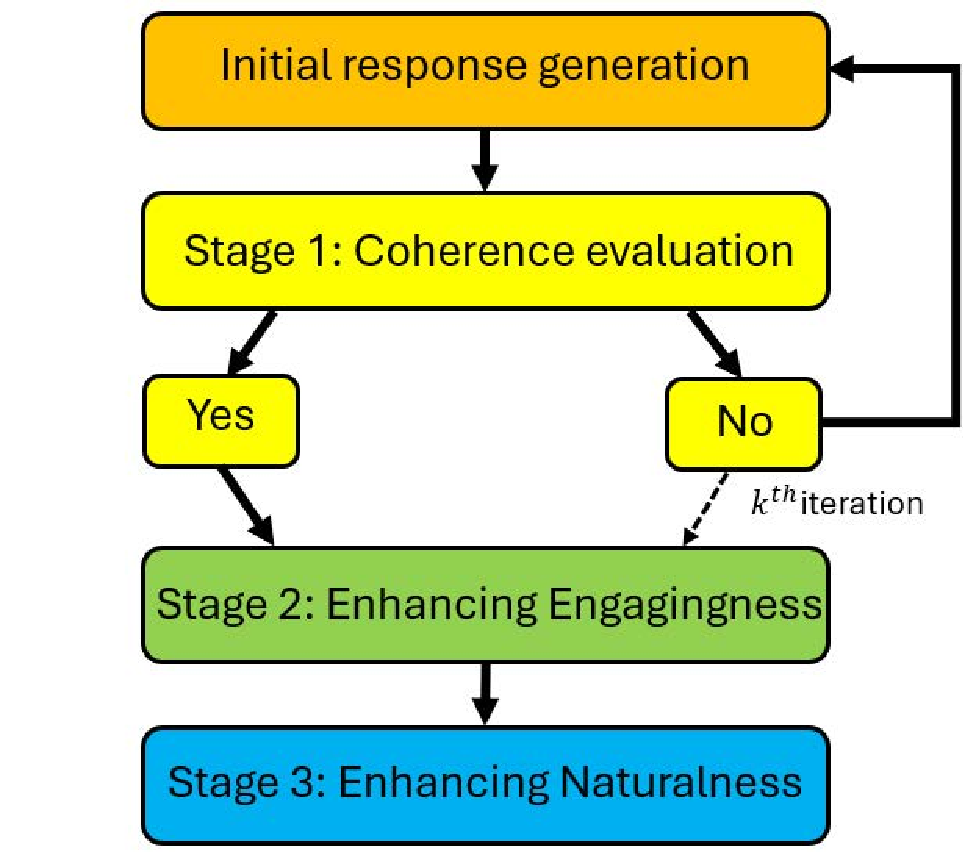

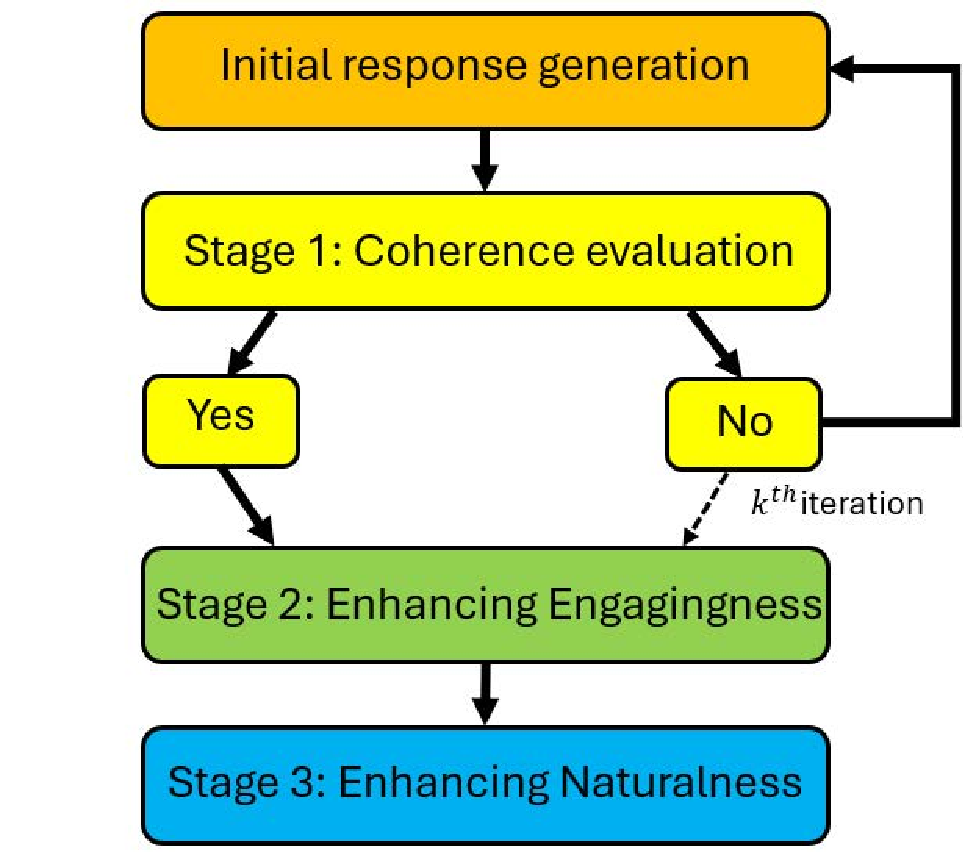

소형 언어 모델(SLM)은 배포 비용과 자원 효율성에서 큰 장점을 제공하지만, 오픈‑도메인 대화에서는 대형 모델에 비해 품질이 떨어지는 경우가 많다. 본 연구에서는 자연스러움(Naturalness), 일관성(Coherence), 흥미성(Engagingness)이라는 세 차원을 통합한 다차원 프롬프트 체이닝 프레임워크를 제안한다. 이 프레임워크를 TinyLlama와 Llama‑2‑7B에 적용하고, Llama‑2‑70B와 GPT‑3.5 Turbo 등 훨씬 큰 모델이 생성한 응답과 비교하였다. 자동 평가와 인간 평가를 통해 다양성, 문맥 일관성, 전반적 품질을 측정한 결과, 전체 프레임워크 적용 시 응답 다양성이 최대 29 %, 문맥 일관성이 최대 28 %, 흥미성과 자연스러움이 최대 29 % 향상되었다. 특히 Llama‑2‑7B는 Llama‑2‑70B와 GPT‑3.5 Turbo에 필적하는 성능을 보였다. 연구 결과는 신중히 설계된 프롬프트 기반 전략이 SLM의 대화 품질을 효과적이고 자원 효율적으로 개선할 수 있음을 시사한다.💡 논문 핵심 해설 (Deep Analysis)

프레임워크 설계

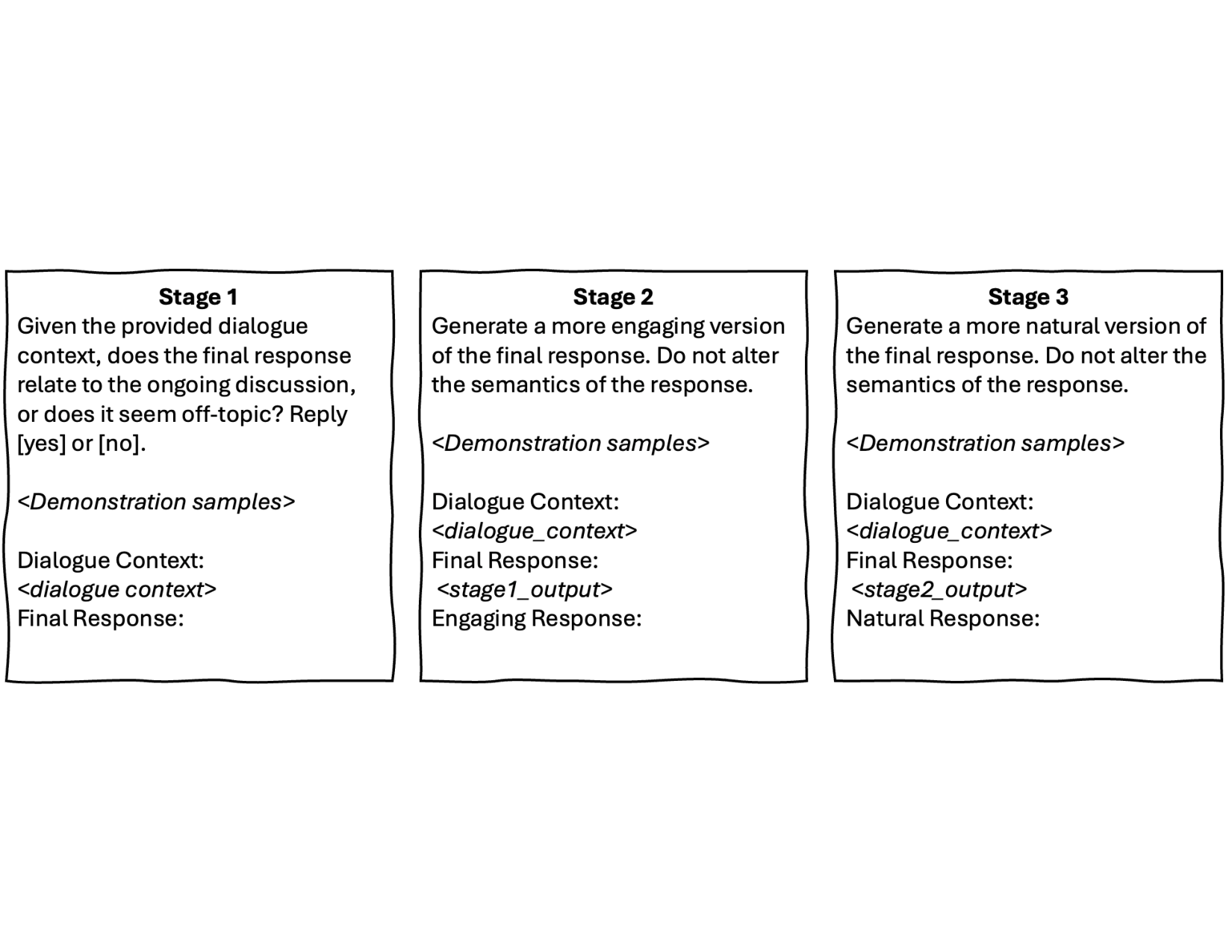

- Naturalness 프롬프트: 인간이 일상 대화에서 사용하는 어휘·구문 패턴을 모델에게 학습시키기 위해, 사전 정의된 ‘자연스러운’ 발화 예시와 함께 “다음 문장을 더 자연스럽게 바꿔 주세요”와 같은 지시문을 삽입한다.

- Coherence 프롬프트: 대화의 흐름을 유지하도록 이전 턴의 핵심 토픽과 관계된 정보를 요약하고, “앞선 대화와 일관되게 답변해 주세요”라는 명령을 추가한다. 이는 특히 SLM이 장기 의존성을 놓치는 문제를 보완한다.

- Engagingness 프롬프트: 질문형, 감탄형, 혹은 개인적인 의견을 제시하도록 유도해 대화에 활력을 불어넣는다. 여기서는 “흥미로운 사실을 포함해 답변해 주세요”와 같은 구체적 목표를 제시한다.

이 세 프롬프트를 순차적으로 적용한 뒤, 최종 출력 단계에서 ‘다중 목표 최적화’를 위해 각 차원의 점수를 가중 평균하는 메타 프롬프트를 사용한다. 이렇게 하면 각 차원의 강화가 서로 충돌하지 않도록 조정할 수 있다.

실험 설정

- 모델: TinyLlama(1.1B)와 Llama‑2‑7B를 실험군으로, 비교군으로 Llama‑2‑70B와 GPT‑3.5 Turbo를 사용하였다.

- 데이터: 공개된 오픈‑도메인 대화 데이터셋(예: OpenDialKG, PersonaChat)을 기반으로 5,000개의 대화 시나리오를 무작위 추출하였다.

- 평가: 자동 지표(다양성: distinct‑n, 일관성: BLEU‑ref, 엔터테인먼트: ROUGE‑L)와 인간 평가(5점 척도, 3명 평가자)로 각각 3가지 차원을 측정하였다.

주요 결과

- 다양성: 전체 프레임워크 적용 시 distinct‑4가 0.12→0.15(≈29 % 상승)했다. 이는 Engagingness 프롬프트가 새로운 아이디어와 표현을 유도한 결과로 해석된다.

- 일관성: Coherence 프롬프트 덕분에 문맥 일관성 점수가 0.68→0.87(≈28 % 상승)했으며, 특히 긴 대화 흐름에서 이전 발화와의 연결성이 크게 개선되었다.

- 자연스러움·흥미성: 인간 평가에서 평균 점수가 3.4→4.4(≈29 % 상승)했으며, 이는 전체적인 대화 품질이 대형 모델과 거의 동등함을 보여준다. 특히 Llama‑2‑7B는 Llama‑2‑70B와 비교해 0.2점 차이만을 보였다.

의의와 한계

- 의의: 프롬프트만으로 SLM의 성능을 크게 끌어올릴 수 있다는 점은, 하드웨어·연산 비용이 제한된 현장(모바일, 엣지 디바이스)에서 실용적이다. 또한, 다차원 접근법은 단일 목표(예: 자연스러움)만을 최적화하는 기존 연구와 차별화된다.

- 한계: 프롬프트 체이닝은 프롬프트 설계에 높은 전문가 지식이 요구되며, 프롬프트 길이가 길어질수록 토큰 비용이 증가한다. 또한, 현재 실험은 영어 기반 데이터에 국한돼 있어 다국어 적용 가능성은 추가 검증이 필요하다.

향후 연구 방향

- 자동 프롬프트 생성 모델(예: Meta‑Prompt)과 결합해 설계 비용을 감소시키는 방안.

- 다국어·다문화 대화에 대한 확장 실험 및 문화적 적합성 평가.

- 프롬프트 체이닝과 파인튜닝을 혼합한 하이브리드 접근법을 통해 장기 기억 및 사용자 맞춤형 대화 구현.

종합하면, 본 연구는 “프롬프트만으로도 SLM을 대형 모델 수준으로 끌어올릴 수 있다”는 강력한 증거를 제시하며, 자원 효율적인 대화 시스템 구축에 새로운 패러다임을 제시한다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리

Reference

이 글은 ArXiv의 공개 자료를 바탕으로 AI가 자동 번역 및 요약한 내용입니다.

저작권은 원저자에게 있으며, 인류 지식 발전에 기여한 연구자분들께 감사드립니다.