법률 문서는 특수한 어휘와 함께 길이가 매우 길어지는 경우가 많아, 전체 문서를 Transformer 기반 모델에 입력하기가 불가능하거나 비용·시간 면에서 비효율적이다. 본 연구에서는 DeBERTa V3와 LSTM을 결합한 분류기를 제안한다. 입력으로는 최대 128 토큰 길이의 짧은 청크 48개를 무작위로 선택하여 사용한다. 또한, 내구성이 뛰어난 실행 솔루션인 Temporal을 활용한 배포 파이프라인을 설계해 안정적이고 견고한 처리 워크플로우를 구현하였다. 최종 모델은 가중 F‑score 0.898을 달성했으며, CPU 환경에서 100개 파일당 중위 처리 시간은 498초였다.

모델 아키텍처는 먼저 DeBERTa V3를 통해 각 청크의 의미적 임베딩을 추출하고, 이를 시계열적으로 LSTM에 입력한다. LSTM은 청크 간의 순서 정보를 어느 정도 보존하면서, 청크별 특징을 종합해 문서 수준의 표현을 만든다. 이 설계는 Transformer의 강력한 언어 이해 능력과 LSTM의 순차적 통합 능력을 결합한 하이브리드 구조라 할 수 있다.

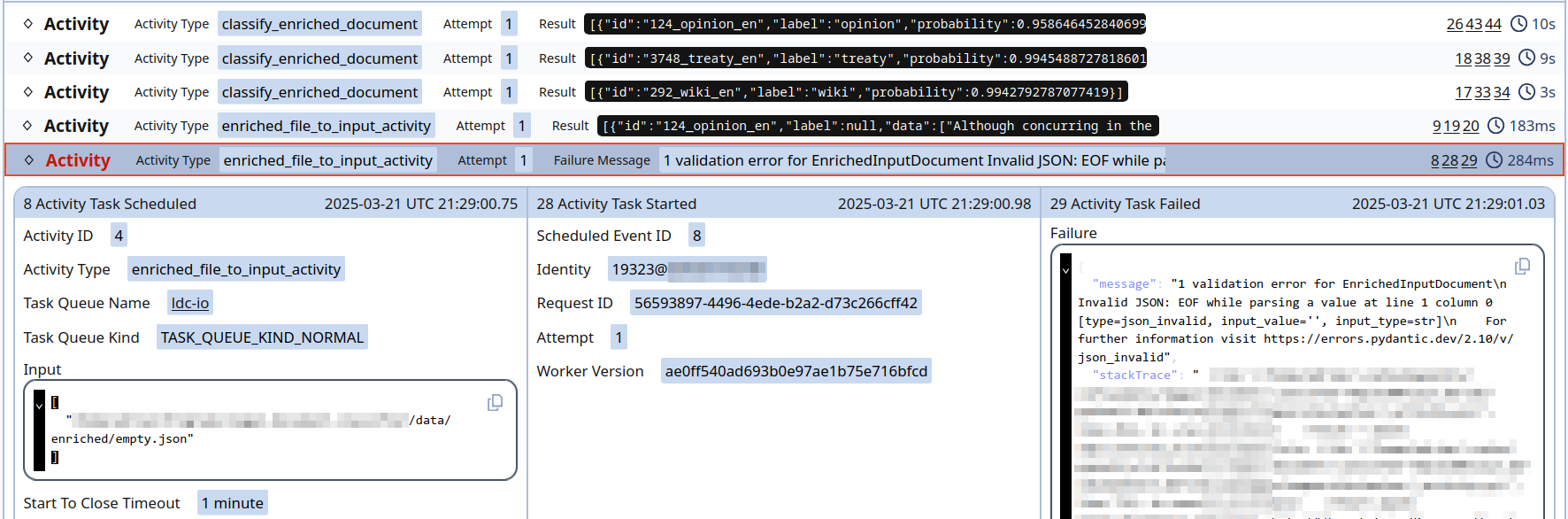

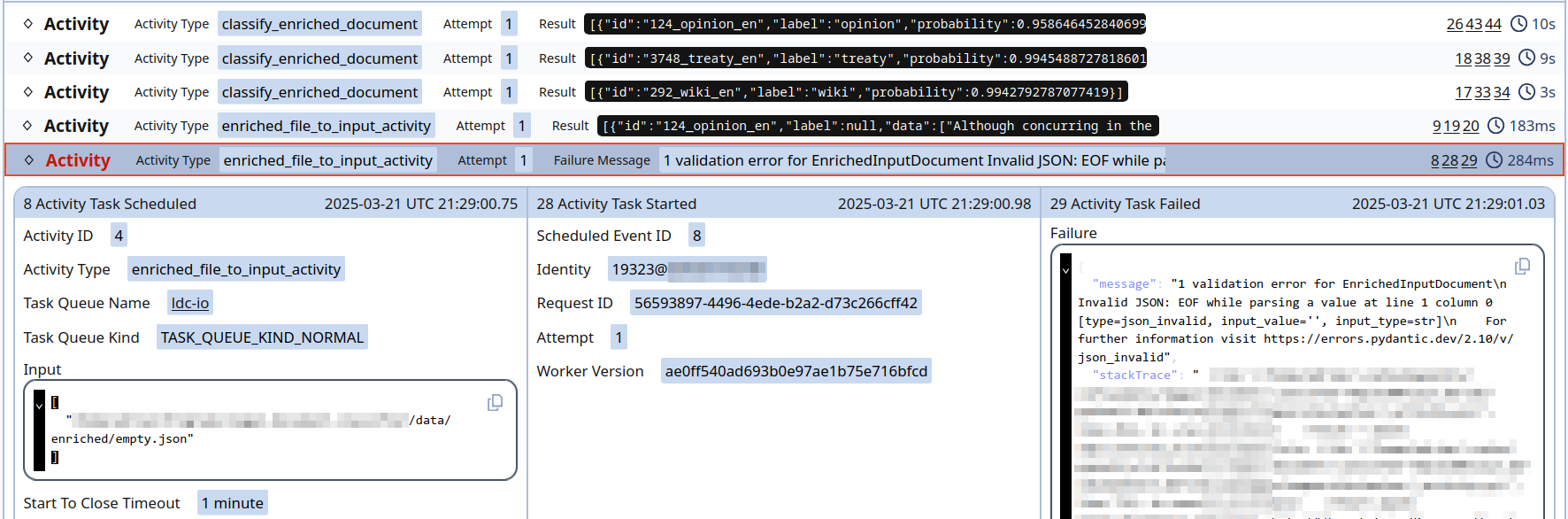

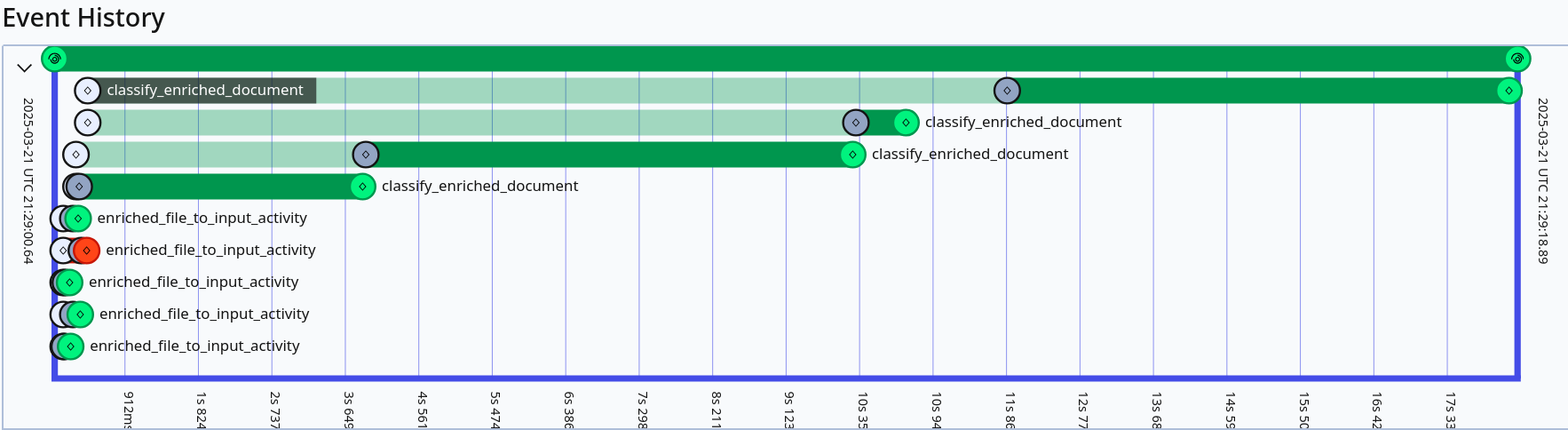

배포 측면에서는 Temporal이라는 내구성 있는 워크플로우 엔진을 활용한다. Temporal은 작업 재시도, 상태 관리, 스케일링 등을 자동화해 대량 파일 처리 시 발생할 수 있는 오류를 최소화한다. 특히 CPU 전용 환경에서도 100파일당 498초라는 중위 처리 시간을 기록했는데, 이는 GPU 없이도 실용적인 서비스 수준을 유지할 수 있음을 의미한다.

성능 평가에서는 가중 F‑score 0.898을 달성했으며, 이는 기존 전체 문서 입력 방식이나 요약 기반 접근법과 비교해 경쟁력 있는 결과다. 다만 무작위 샘플링 특성상 동일 문서에 대해 실행마다 약간의 변동성이 존재할 수 있다. 향후 연구에서는 샘플링 전략을 최적화하거나, 청크 선택에 가중치를 부여해 중요한 섹션을 더 자주 포함하도록 하는 방법을 모색할 여지가 있다. 전반적으로 이 논문은 제한된 연산 자원 하에서 대용량 법률 문서를 효과적으로 분류할 수 있는 실용적인 프레임워크를 제시한다.

## 법적 문서 분류: 짧은 랜덤 조각을 이용한 접근

법률 AI는 인공지능 기술을 활용하여 법률 전문가들의 업무 부담과 중복을 줄이는 데 사용됩니다 (Zhong et al., 2020). 물론, 법률 AI는 새로운 개념이 아니며 (Dale, 2019), 법적 문서 처리는 여전히 도전 과제입니다.

법적 문서의 다양성은 그 길이, 어휘, 구조, 주체성, 범위 등 여러 요인에서 기인하며 (Mitchell, 2014; Trautmann, 2023), 이러한 특성을 완화하기 위해 전문 코퍼스를 사용하여 훈련 도구를 개발하는 방법이 있습니다 (Chalkidis et al., 2020). 그러나 문서의 길이는 여전히 주요 도전 과제입니다. 긴 문서를 처리할 경우 맥락을 유지하는 것이 어려워지며, 특히 Wagh et al. (2021)의 연구에 따르면 문서 길이가 길어질수록 관련성이 실제로 중요한 작업에 대한 올바른 맥락을 유지하기가 더욱 힘들어집니다. 또한, Transformed 기반 기술, 특히 BERT (Devlin et al., 2019)와 같은 모델은 긴 입력에 메모리 소비가 급증합니다 (Vaswani et al., 2017).

더욱이, 대규모 언어 모델(LLM)의 등장에도 불구하고, 이러한 모델의 사용에는 비용과 위험이 따릅니다 (Karla Grossenbacher, 2023; Cassandre Coyer and Isha Marathe, 2024; Fields et al., 2024).

따라서, 본 연구에서는 긴 법적 문서를 처리할 수 있는 분류기를 제시하며, 내부 CPU 서버에 배포 가능하도록 설계되었습니다. 이를 위해 DeBERTa V3 (He et al., 2021)와 LSTM을 기반으로 한 문서 분류기를 개발했습니다. 또한, Temporal2를 사용하여 효율적인 워크플로우를 생성하고, 분류기의 배포에 집중했습니다.

제안된 모델은 다양한 길이와 범위의 법적 문서를 훈련하고 테스트하여 89.0%의 평균 가중 F-score를 달성했습니다. 또한, 498초(100개 문서 처리당)의 처리 시간으로 Temporal을 사용하여 서버에 배포되었습니다.

관련 연구는 긴 문서를 분할하거나 작은 조각으로 나누어 BERT (Devlin et al., 2019) 모델에 입력하는 방법에 초점을 맞추고 있습니다. 예를 들어, Pappagari et al. (2019)은 긴 문서를 200토큰 단위로 세분화하고, 이를 BERT 모델에 입력한 후 LSTM 또는 트랜스포머 레이어에 전달합니다. CogLXT (Ding et al., 2020)는 키 문장을 추출하여 BERT 모델에 입력하는 분류기를 제시하며, Park et al. (2022)은 텍스트랭킹(TextRank)을 사용하여 관련 문장을 선택하거나 무작위로 선택한 후 초기 512토큰의 문서에 연결합니다.

다른 연구들은 입력 크기를 늘리는 트랜스포머 기반 모델에 집중했습니다. 가장 좋은 예로 Longformer (Beltagy et al., 2020)는 최대 4,096토큰을 처리할 수 있는 모델입니다. 그러나 이러한 모델은 일반적으로 메모리 소비와 긴 처리 시간이 문제입니다 (Park et al., 2022).

법률 분야의 관련 연구로는 Chalkidis et al. (2019)이 법적 문서 분류를 위해 Doc2Vec 임베딩(Le and Mikolov, 2014)과 BiGRU에 Label-Wise Attention 네트워크(Mullenbach et al., 2018)를 결합한 모델을 제시했습니다. 또한, Wan et al. (2019)은 법적 문서 분류를 위해 Doc2Vec 임베딩과 BiLSTM을 사용하여 조각 주의 레이어를 추가했습니다.

LegalDB (Bambroo and Awasthi, 2021)과 Lawformer (Xiao et al., 2021)는 각각 DistillBERT (Sanh et al., 2020)와 중국어 RoBERTa 모델(Cui et al., 2021)을 Longformer 모델로 변환했습니다. 또한, Mamakas et al. (2022)은 LegalBERT (Chalkidis et al., 2020)를 법적 계층 BERT로 변환하고, 법적 Longformer 모델을 개발하여 최대 8,192토큰을 처리할 수 있도록 했습니다.

D2GCFL (Wang et al., 2022)은 계약서와 같은 법적 문서를 분류하기 위해 관계와 표현을 그래프로 변환한 후 그래프 주의 네트워크에 전달하는 모델입니다. Li et al. (2023)은 작은 조각으로 분할된 법적 계약을 필터링한 후, 미세 조정된 RoBERTa (Liu et al., 2019) 모델에 입력합니다. Trautmann (2023)은 요약 체인을 사용하여 법적 문서를 분류하는 프롬프트 체인 방법을 제시합니다.

본 연구는 Jus Mundi3라는 법률 테크 회사가 내부 필요를 충족하기 위해 개발한 도구입니다. 즉, Jus Mundi는 다양한 서비스와 도구에 사용될 수 있는 효율적이고 단순하며 프라이버시에 초점을 맞춘 법적 문서 분류기를 만들고자 했습니다.

목표:

- 프라이버시 보호: LLMs의 데이터 피드백을 통해 모델을 훈련하는 것은 법률 분야에서 개인 정보 유출 위험을 초래할 수 있습니다.

- 속도: 분류기는 실시간 도구에 사용되어야 하므로 속도가 필수적인 요소입니다.

- 단순성: 복잡한 아키텍처는 유지 보수가 어려울 수 있으며, 프롬프트 기반 분류기와 같은 새로운 접근 방식은 모델 업데이트 시 문제가 발생할 수 있습니다.

- 비용 효율성: 일부 고급 모델은 강력한 GPU를 필요로 하며, 장기적인 운영 비용이 높을 수 있습니다. 따라서 저렴한 하드웨어로 실행 가능한 솔루션을 개발하는 것이 중요합니다.

…(본문이 길어 생략되었습니다. 전체 내용은 원문 PDF를 참고하세요.)…

이 글은 ArXiv의 공개 자료를 바탕으로 AI가 자동 번역 및 요약한 내용입니다.

저작권은 원저자에게 있으며, 인류 지식 발전에 기여한 연구자분들께 감사드립니다.