자율 기억 검색으로 LLM 답변 품질을 극대화하는 MemR³ 시스템

📝 원문 정보

- Title: MemR$^3$: Memory Retrieval via Reflective Reasoning for LLM Agents

- ArXiv ID: 2512.20237

- 발행일: 2025-12-23

- 저자: Xingbo Du, Loka Li, Duzhen Zhang, Le Song

📝 초록 (Abstract)

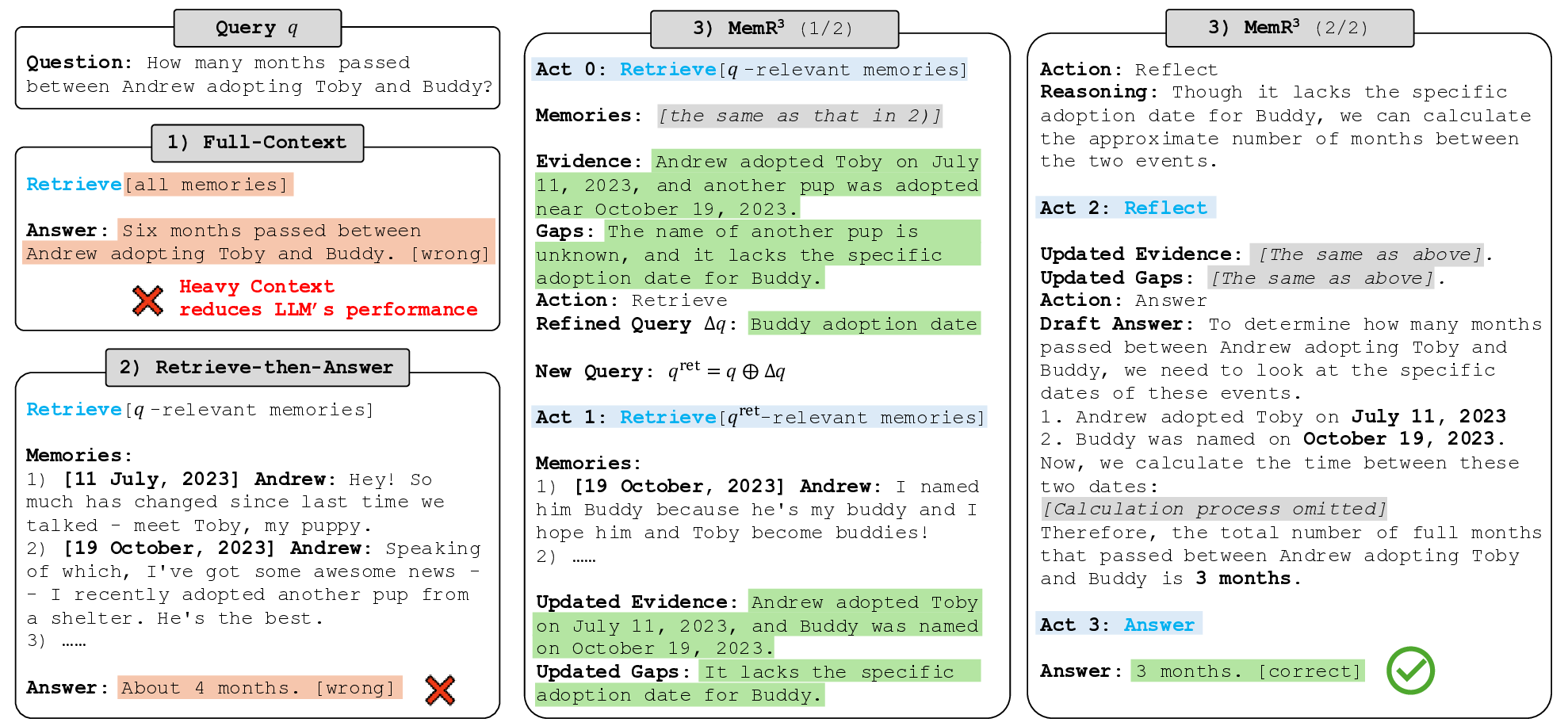

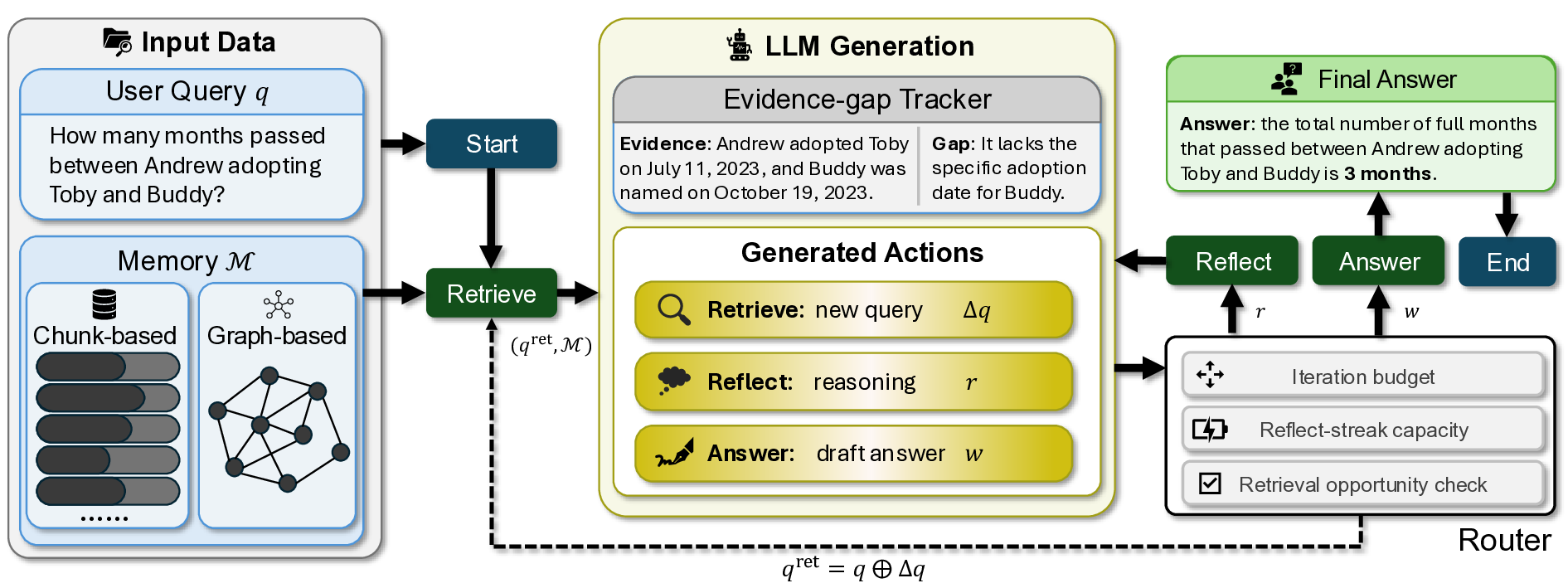

기존 LLM 에이전트의 메모리 시스템은 압축·저장 최적화에 치중하고, 기억 검색의 폐쇄형 제어는 소홀히 다루어졌다. 이를 개선하고자 우리는 MemR³라는 자율적이고 정확하며 기존 메모리와 호환 가능한 에이전트 시스템을 설계하였다. MemR³는 (1) 검색·반성·응답 중 최적 행동을 선택하는 라우터와 (2) 답변 과정을 투명하게 보여주고 증거 수집을 추적하는 전역 증거‑갭 트래커라는 두 핵심 메커니즘을 갖는다. 이 설계는 전통적인 ‘검색‑후‑답변’ 파이프라인을 탈피해 폐쇄‑루프 제어를 도입, 에이전트가 스스로 언제 추가 정보를 검색할지 판단하도록 만든다. Lo‑CoMo 벤치마크 실험에서 MemR³는 LLM‑as‑a‑Judge 점수에서 강력한 베이스라인을 앞섰으며, 특히 GPT‑4.1‑mini 백엔드에서 RAG(+7.29 %)와 Zep(+1.94 %) 성능을 전반적으로 향상시켜 기존 메모리 저장소에 플러그‑앤‑플레이 방식으로 적용 가능함을 입증하였다.💡 논문 핵심 해설 (Deep Analysis)

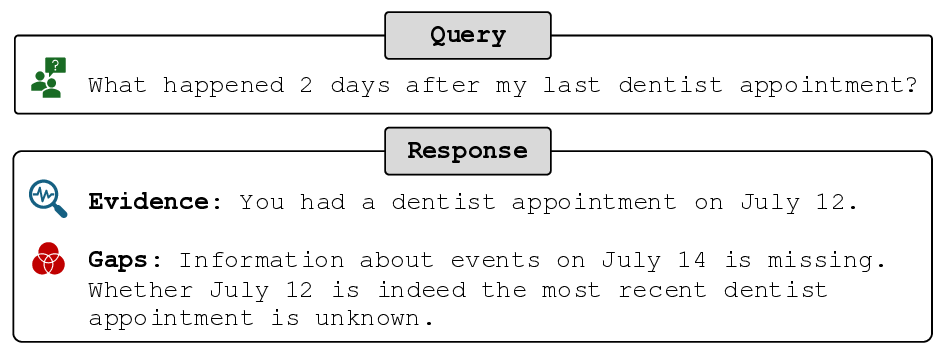

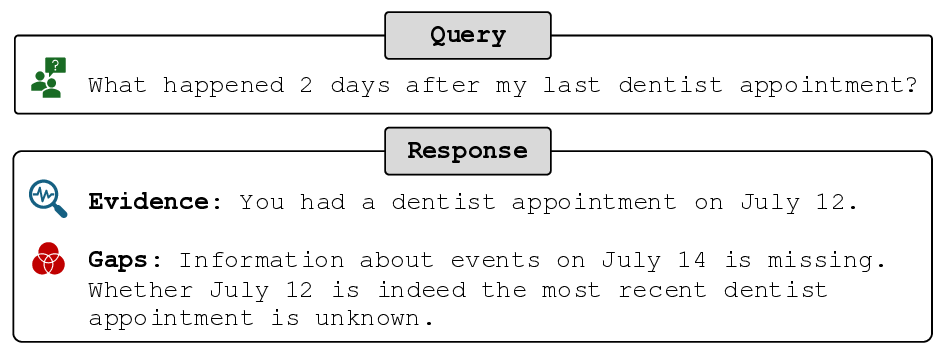

MemR³는 이러한 문제점을 해결하기 위해 두 가지 혁신적인 구성요소를 도입한다. 첫 번째는 ‘라우터’이다. 라우터는 현재 질문에 대한 상태를 평가하고, ‘retrieve(추가 검색)’, ‘reflect(내부 사고)’, ‘answer(응답)’ 중 최적의 행동을 선택한다. 이때 라우터는 LLM 자체를 메타‑프롬프트로 활용해 행동 정책을 학습하며, 행동 선택은 답변 품질을 직접적인 보상 신호로 삼는다. 두 번째는 ‘전역 증거‑갭 트래커’이다. 트래커는 질문‑답변 과정 전반에 걸쳐 어떤 증거가 확보되었고, 어떤 증거가 아직 부족한지를 실시간으로 기록한다. 이를 통해 에이전트는 “증거가 충분히 모였는가?”라는 명시적인 판단 기준을 갖게 되며, 불확실성이 남아 있을 경우 자동으로 추가 검색을 수행한다.

이러한 폐쇄‑루프 제어는 전통적인 ‘검색‑후‑답변’ 파이프라인과 근본적으로 다르다. 기존 파이프라인은 한 번의 검색 결과를 받아 바로 답변을 생성하는 일방향 흐름이지만, MemR³는 답변 과정 중에 지속적으로 증거‑갭을 모니터링하고, 필요 시 반복적으로 검색·반성을 수행한다. 결과적으로 모델은 보다 풍부하고 일관된 근거를 바탕으로 답변을 생성하게 된다.

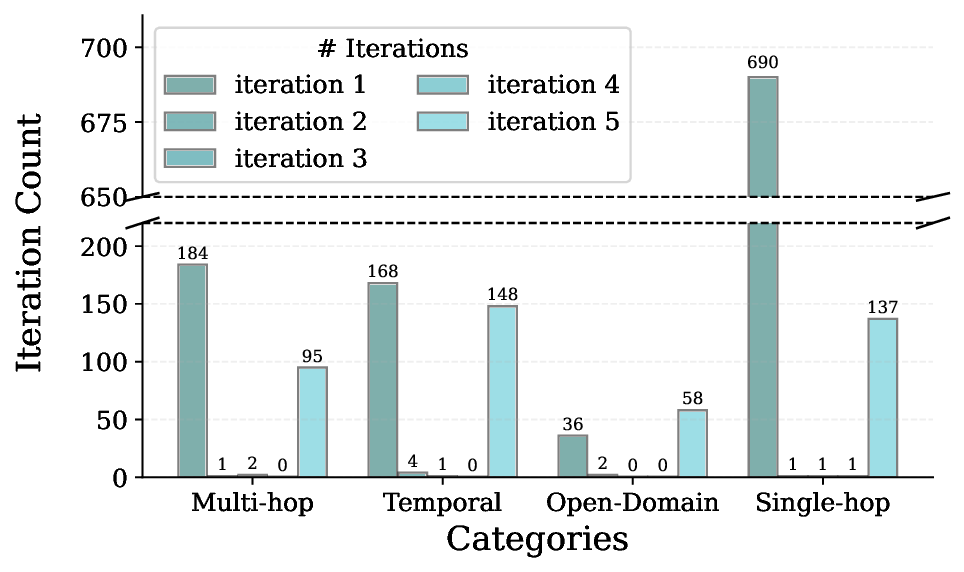

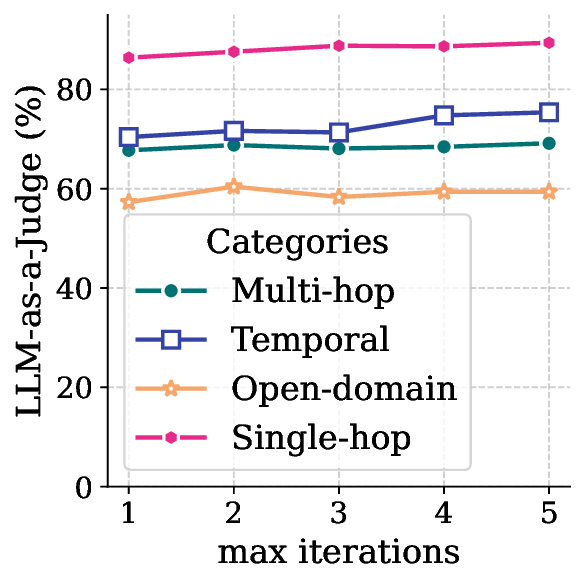

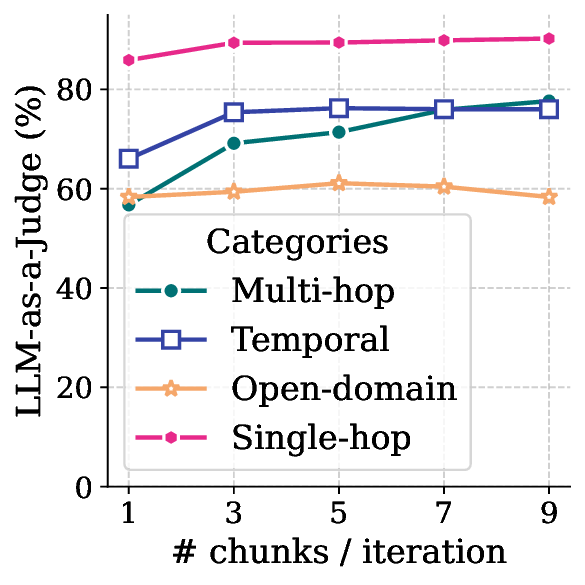

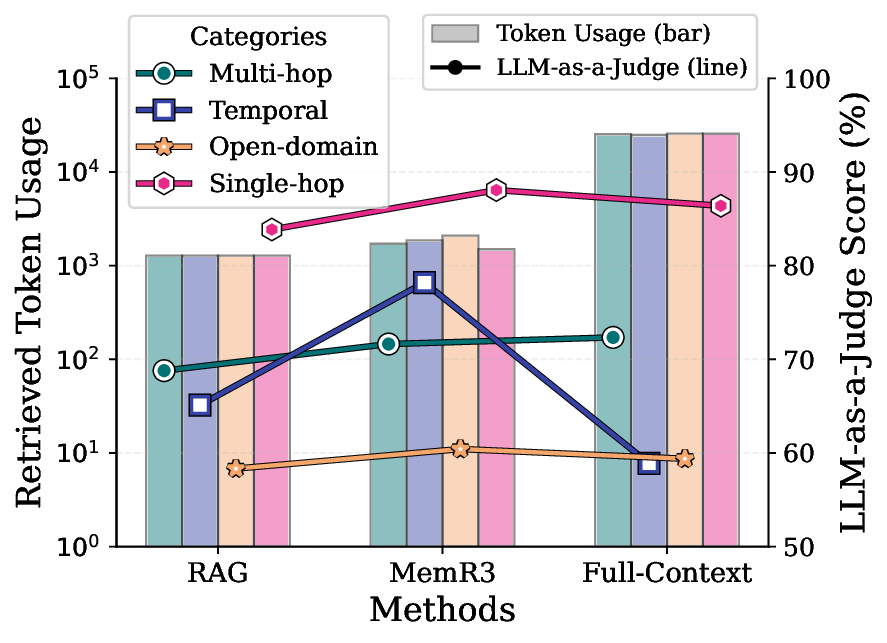

실험은 Lo‑CoMo(Logic‑Consistent‑Memory) 벤치마크를 사용해 수행되었으며, 평가 메트릭으로는 LLM‑as‑a‑Judge 점수를 채택하였다. MemR³는 GPT‑4.1‑mini 백엔드에서 RAG 기반 시스템 대비 7.29 % 상승, Zep 기반 시스템 대비 1.94 % 상승을 기록했다. 특히 ‘증거‑갭 트래커’가 활성화된 경우, 복합 추론 질문에서 정답률이 현저히 개선되었으며, 이는 메모리 검색이 단순 저장·압축을 넘어 의사결정 과정에 직접 통합될 때 얻을 수 있는 시너지 효과를 입증한다.

마지막으로, MemR³는 기존 메모리 저장소와 플러그‑앤‑플레이 방식으로 호환된다. 즉, 현재 운영 중인 벡터 데이터베이스나 외부 지식 베이스에 별도의 재구성 없이 라우터와 트래커만 추가하면 바로 적용 가능하다. 이는 연구 커뮤니티와 산업 현장에서 메모리 기반 LLM 에이전트의 성능을 손쉽게 향상시킬 수 있는 실용적인 솔루션을 제공한다는 점에서 큰 의미가 있다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리