대규모 임상 벤치마크 라벨 품질 개선을 위한 LLM 기반 스튜어드십 프로세스

📝 원문 정보

- Title: Scalable Stewardship of an LLM-Assisted Clinical Benchmark with Physician Oversight

- ArXiv ID: 2512.19691

- 발행일: 2025-12-22

- 저자: Junze Ye, Daniel Tawfik, Alex J. Goodell, Nikhil V. Kotha, Mark K. Buyyounouski, Mohsen Bayati

📝 초록 (Abstract)

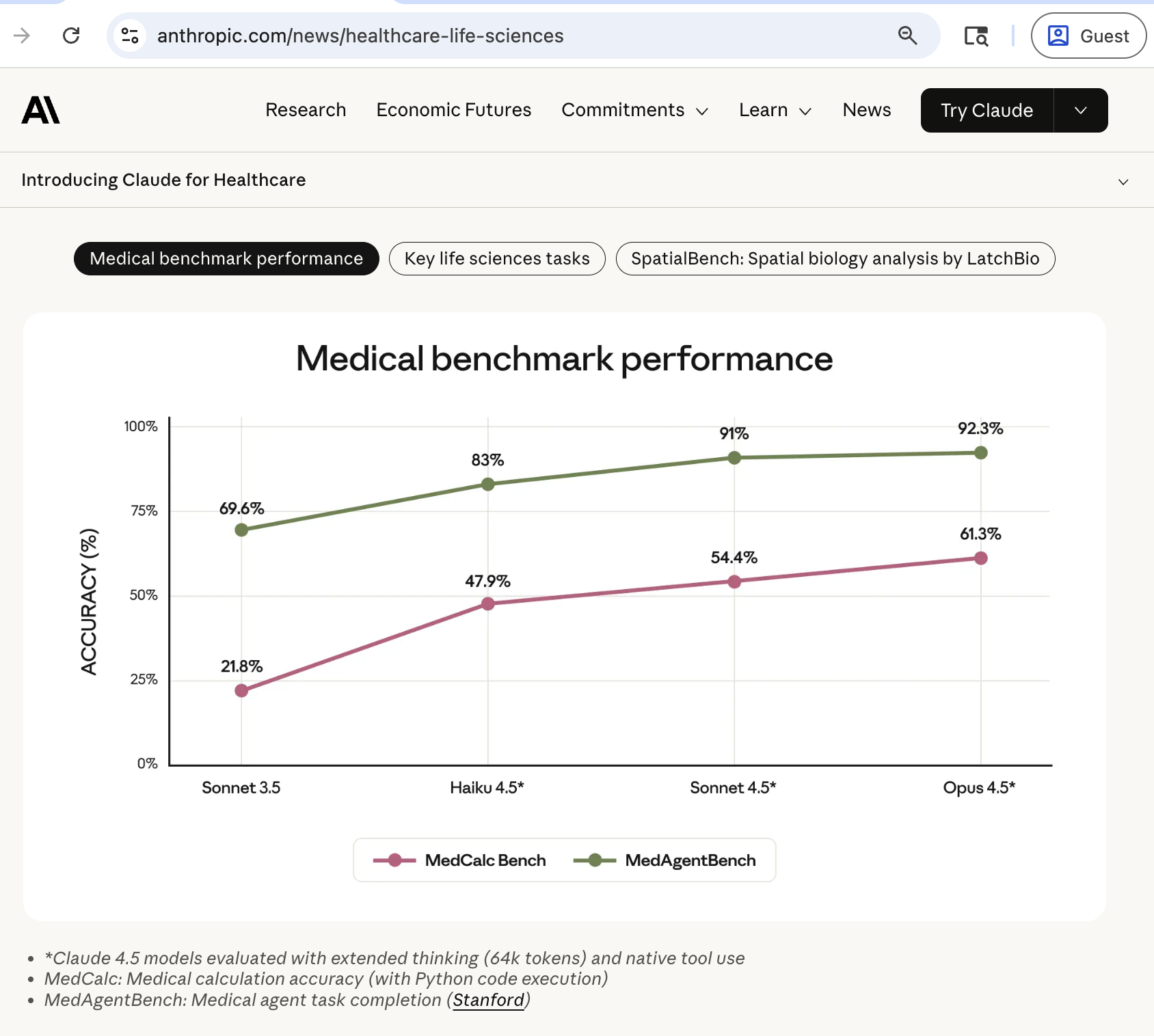

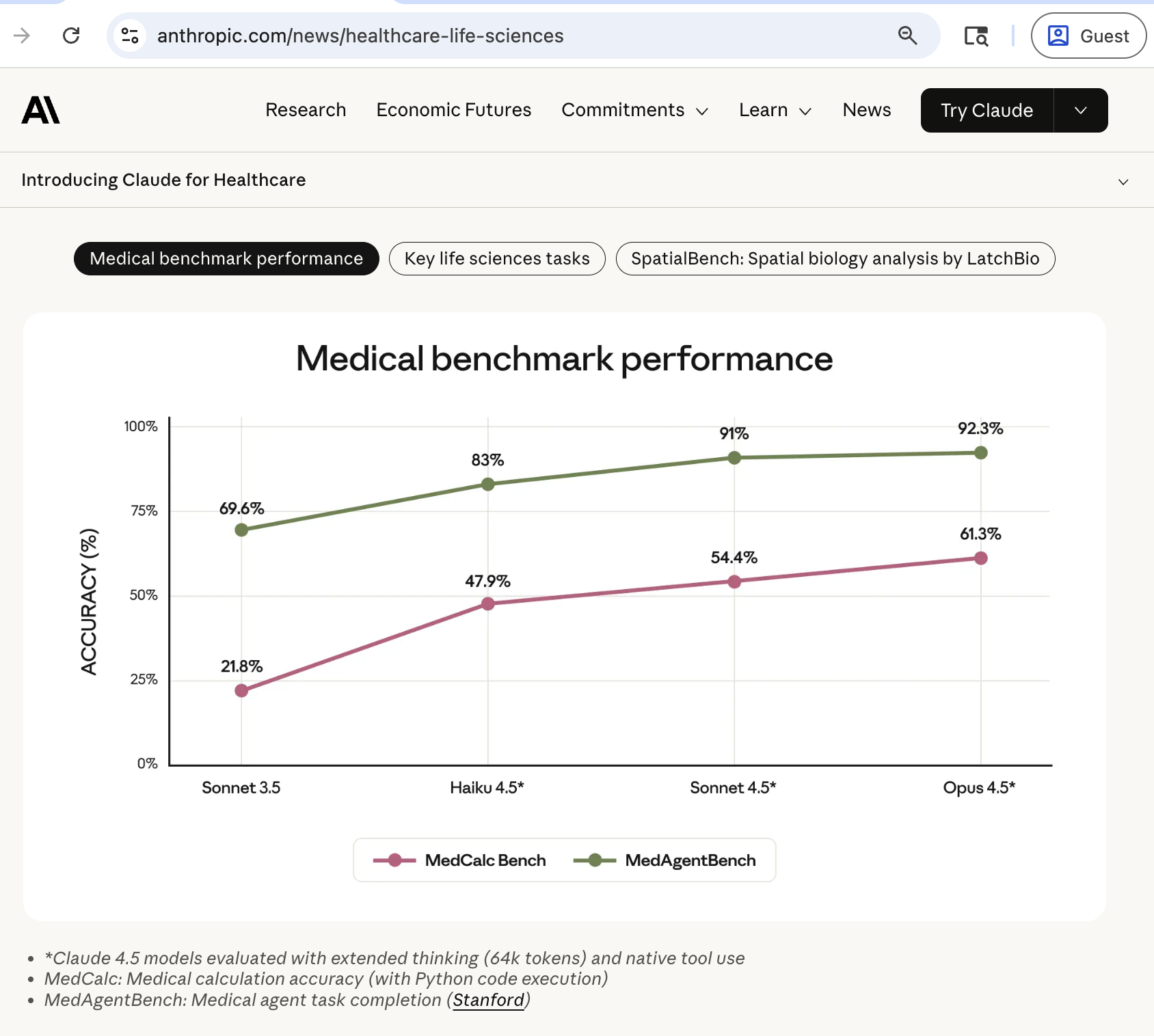

배경: 글래스고우 혼수 척도와 Charlson 동반질환 지수와 같은 의료 점수는 텍스트 및 표형 환자 데이터를 표준화된 위험 지표로 변환하여 트리아지, 치료, 예후 예측 업무를 보조한다. 기존에는 임상의가 수작업으로 점수를 산출했으며, 반복적인 작업이 큰 사무 부담을 초래한다. MedCalc‑Bench는 최근 55개의 일반적인 계산 작업을 자동화할 수 있는 대형 언어 모델(LLM)의 효율성을 평가하기 위한 대규모 임상 벤치마크를 제시했다. 그러나 수작업 라벨링 비용을 절감하기 위해 MedCalc‑Bench 자체가 GPT‑3.5와 GPT‑4를 이용해 기준 점수 라벨을 생성했으며, 이 과정에서 기존 모델의 편향이 라벨에 내재될 가능성이 있다. 본 연구는 이러한 기준 라벨이 임상적으로 얼마나 부정확한지를 평가하고, 라벨 품질을 향상시킬 수 있는 확장 가능한 방안을 모색한다.방법: 우리는 MedCalc‑Bench 라벨을 대규모로 감사하고 개선하기 위한 단계적 스튜어드십 프로세스를 개발하였다. 이 프로세스는 두 개의 별도 지식 기반 LLM 에이전트 워크플로우로 시작한다. 첫 번째는 원본 테스트 케이스와 라벨 생성 메타데이터를 감사하는 작업이며, 두 번째는 원본 학습·테스트 케이스를 원칙에 따라 독립적으로 재라벨링하는 작업이다. 자동화된 트리아지 시스템은 원본 라벨과 재계산 라벨 간 불일치가 큰 사례를 식별해 제한된 의사 전문가 예산을 가장 논쟁이 되는 사례에 집중하도록 돕는다. 또한, 라벨 노이즈가 모델 성능에 미치는 영향을 정량화하기 위해 통제된 강화학습(RL) 실험을 수행했으며, 원본 라벨과 재라벨링된 라벨로 학습된 모델을 비교하였다.

💡 논문 핵심 해설 (Deep Analysis)

이러한 문제를 해결하기 위해 저자들은 두 단계의 에이전트 기반 워크플로우를 도입했다. 첫 번째 워크플로우는 메타데이터와 라벨 생성 과정을 추적·감사함으로써 라벨링 과정의 투명성을 확보한다. 두 번째 워크플로우는 ‘첫 원칙’ 접근법을 적용해 인간 전문가가 정의한 공식과 임상 가이드라인에 따라 라벨을 재계산한다. 이 과정에서 자동화된 트리아지 시스템이 원본 라벨과 재라벨 간 차이가 큰 사례를 자동으로 선별해, 제한된 전문가 자원을 효율적으로 배분한다는 점은 비용‑효율성 측면에서 큰 장점이다.

또한, 라벨 노이즈가 모델 학습에 미치는 영향을 강화학습(RL) 실험을 통해 정량화한 것은 실용적인 통찰을 제공한다. 원본 라벨을 사용한 모델과 재라벨링된 라벨을 사용한 모델을 비교함으로써, 라벨 품질 개선이 실제 성능 향상으로 이어짐을 입증한다. 이는 라벨링 품질 관리가 모델 개발 파이프라인에서 필수적인 단계임을 실증적으로 보여준다.

하지만 몇 가지 한계점도 존재한다. 첫째, 재라벨링 과정에 사용된 LLM 자체도 여전히 편향을 내포하고 있을 가능성이 있다. 저자들은 ‘지식 기반’이라고 표현했지만, 구체적인 프롬프트 설계와 검증 절차가 상세히 기술되지 않아 재라벨의 절대적 정확성을 보장하기 어렵다. 둘째, 의사 전문가의 피드백을 제한된 예산으로 집중한다는 전략은 고위험 사례에 초점을 맞추지만, 전체 데이터셋의 라벨 품질을 균등하게 향상시키지는 못한다. 셋째, 강화학습 실험은 특정 모델 아키텍처와 학습 설정에 국한되어 있어, 다른 LLM이나 도메인에 일반화 가능한지 검증이 필요하다.

향후 연구에서는 (1) 다중 전문가 합의를 통한 라벨 검증, (2) 라벨링 프로세스에 대한 메타‑학습 기법 도입, (3) 라벨 품질 개선이 실제 임상 의사결정에 미치는 영향을 전향적 임상시험으로 평가하는 것이 바람직하다. 또한, 라벨링 자동화와 인간 검증의 최적 균형점을 찾기 위한 비용‑효용 분석도 중요한 과제로 남는다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리