대형 언어 시각 모델 기반 자율주행 궤적 계획 어시스턴트 LLaViDA

📝 원문 정보

- Title: LLaViDA: A Large Language Vision Driving Assistant for Explicit Reasoning and Enhanced Trajectory Planning

- ArXiv ID: 2512.18211

- 발행일: 2025-12-20

- 저자: Yudong Liu, Spencer Hallyburton, Jiwoo Kim, Yueqian Lin, Yiming Li, Qinsi Wang, Hui Ye, Jingwei Sun, Miroslav Pajic, Yiran Chen, Hai Li

📝 초록 (Abstract)

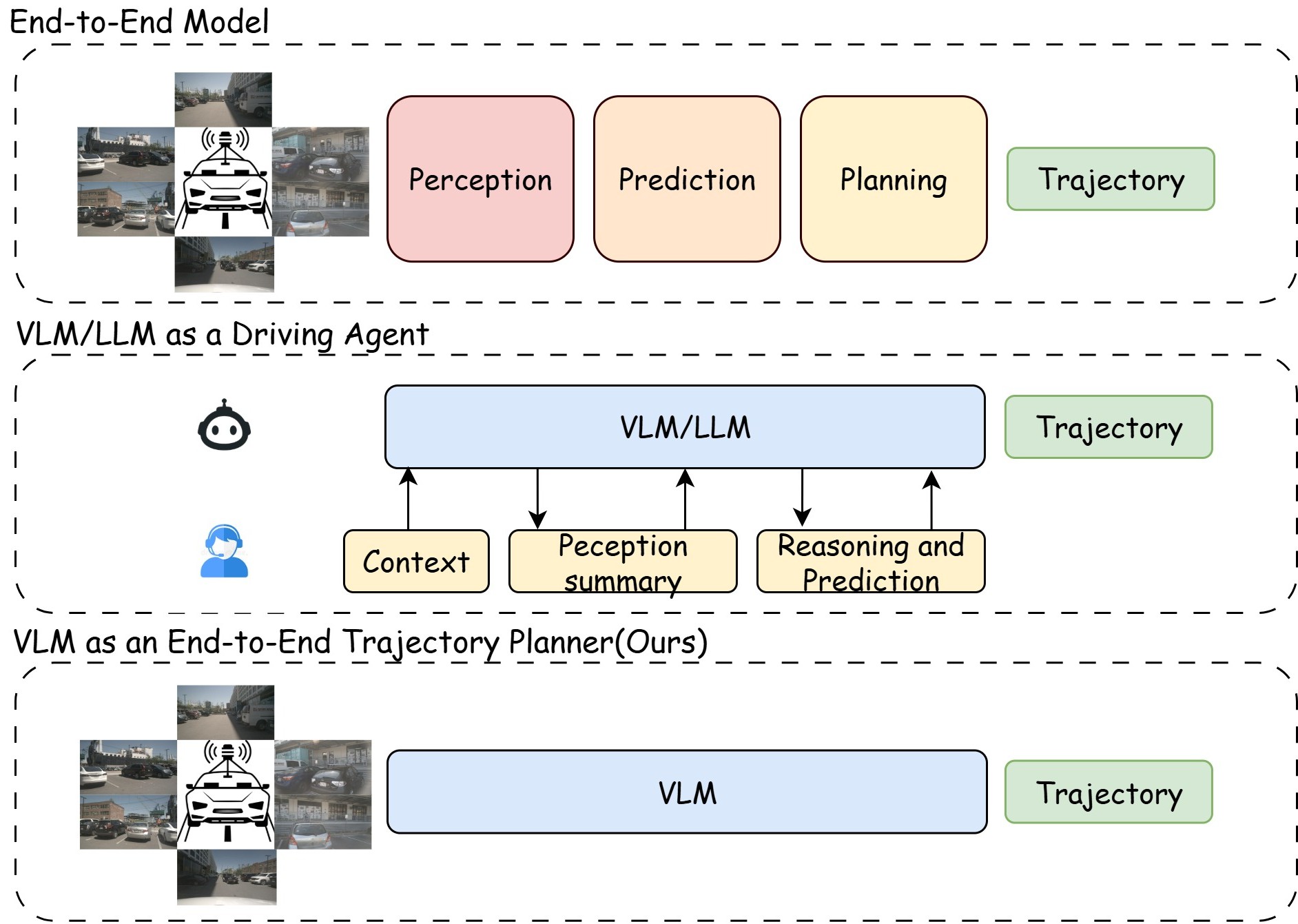

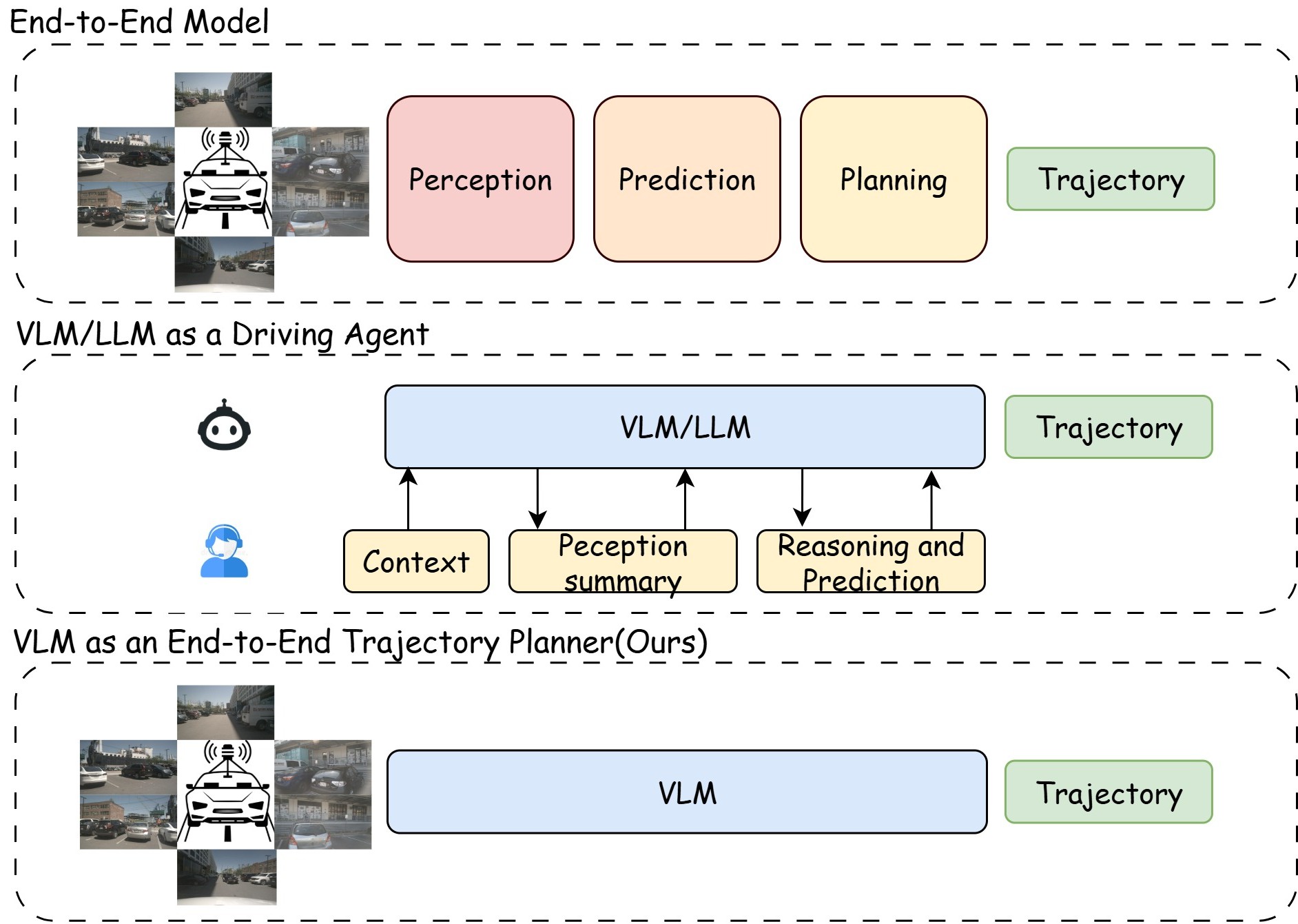

궤적 계획은 자율주행 시스템에서 핵심이면서도 어려운 과제이다. 기존 엔드‑투‑엔드 플래너는 악천후, 예측 불가능한 인간 행동, 복잡한 도로 구조와 같은 상황에서 일반화 능력이나 소수 샷 학습 능력이 부족해 성능이 급격히 저하된다. 본 연구에서는 Vision‑Language Model(VLM)을 활용해 객체 움직임 예측, 의미적 정합, 그리고 체인‑오브‑생각(Chain‑of‑Thought) 추론을 수행하는 대형 언어·시각 운전 어시스턴트 LLaViDA를 제안한다. 두 단계 학습 파이프라인(감독‑미세조정 후 궤적 선호 최적화(Trajectory Preference Optimization, TPO))을 통해 회귀 기반 감독을 주입함으로써 장면 이해와 궤적 계획 능력을 동시에 강화한다. NuScenes 벤치마크의 오픈‑루프 궤적 계획 과제에서 LLaViDA는 평균 ℓ2 궤적 오차 0.31 m, 충돌률 0.10%를 기록하며 최신 엔드‑투‑엔드 및 최근 VLM/LLM 기반 베이스라인을 능가한다. 코드와 모델은 GitHub에 공개된다.💡 논문 핵심 해설 (Deep Analysis)

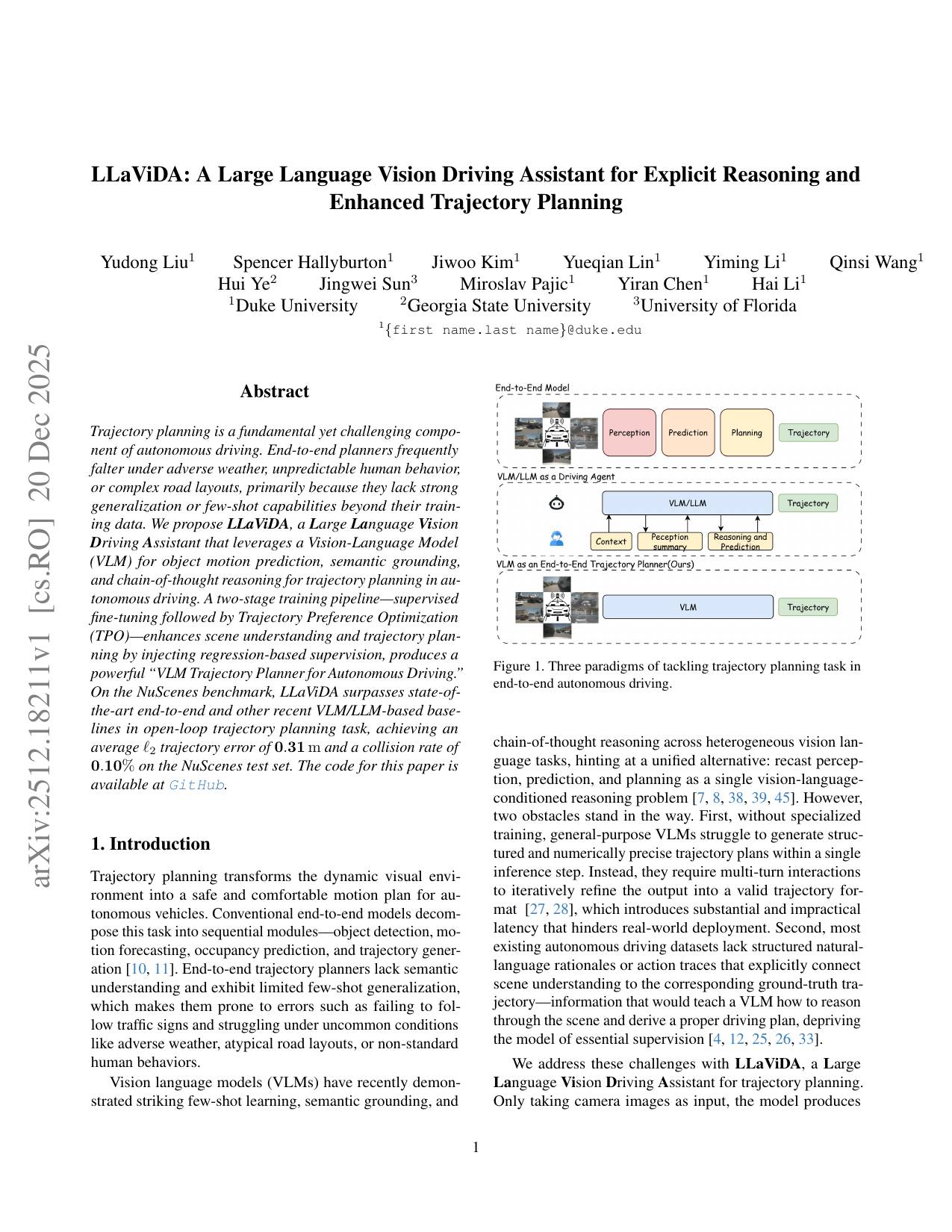

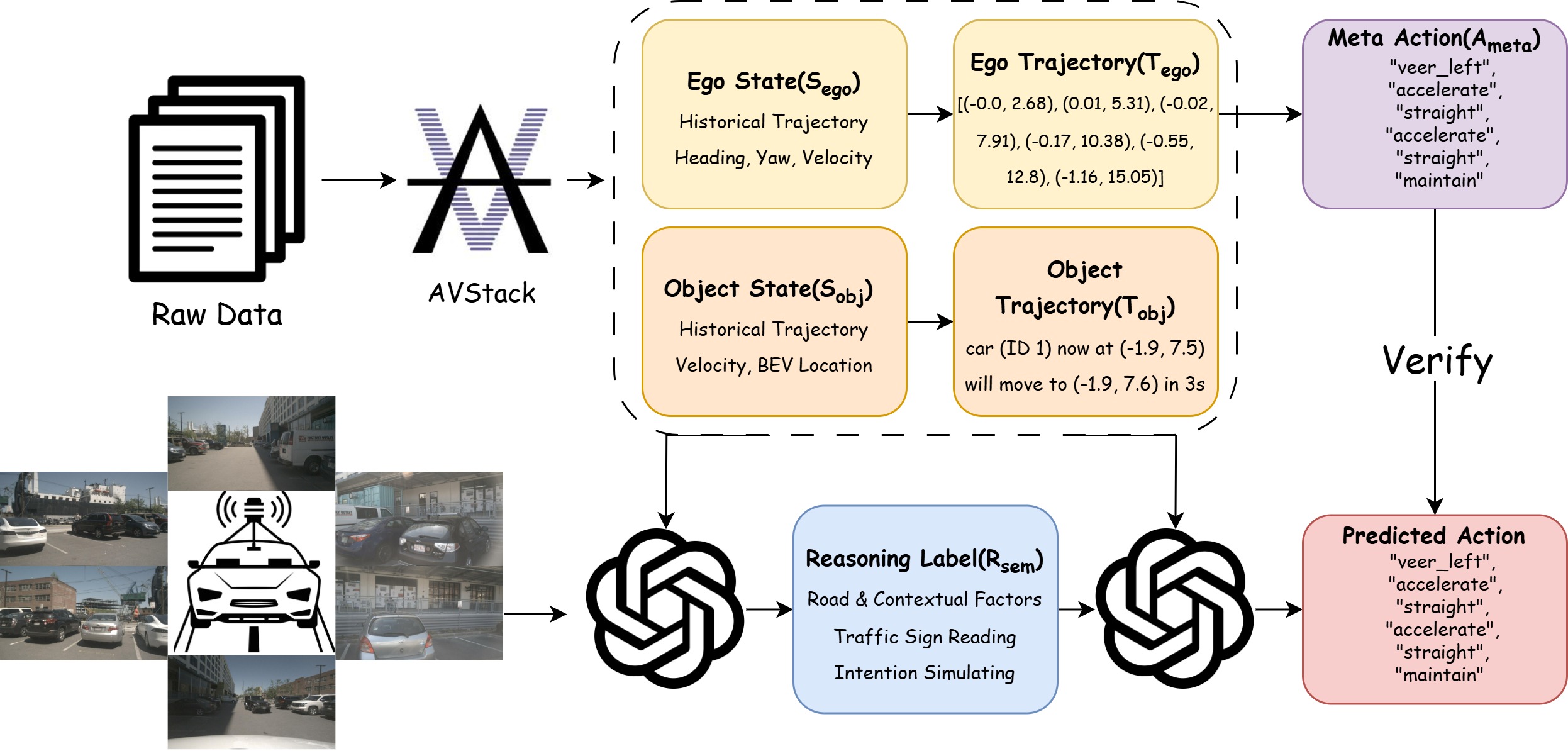

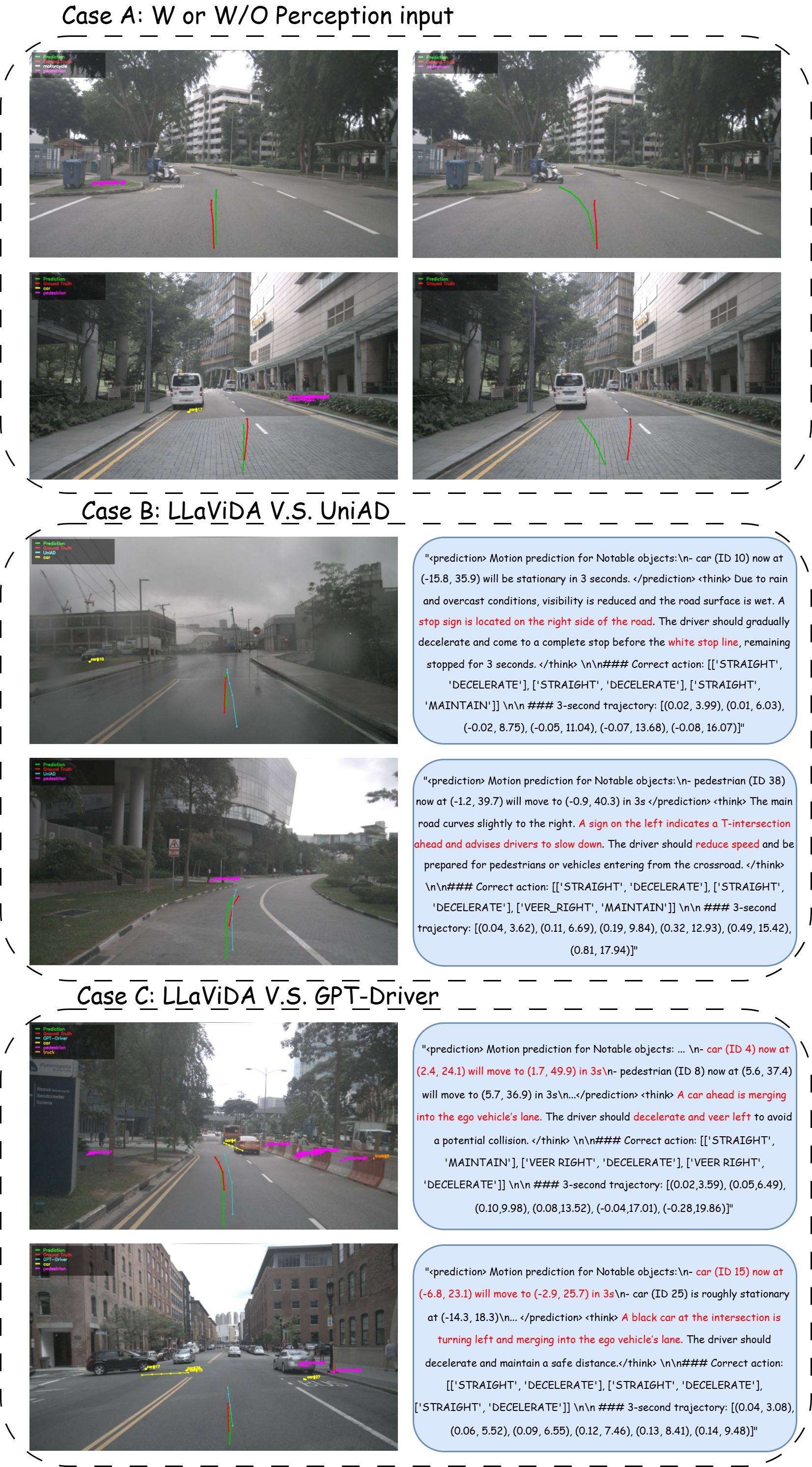

LLaViDA는 이러한 한계를 극복하기 위해 Vision‑Language Model을 핵심 엔진으로 채택한다. VLM은 이미지와 텍스트를 동시에 이해하도록 사전 학습된 대형 모델로, 객체 검출·분류뿐 아니라 “이 객체가 앞으로 어떻게 움직일 것인가”, “현재 교통 상황에서 어떤 행동이 합리적인가”와 같은 질문에 자연어 형태로 답변할 수 있다. 논문에서는 VLM에 체인‑오브‑생각(Chain‑of‑Thought) 프롬프트를 적용해 단계별 추론 과정을 유도한다. 예를 들어, “앞차가 급정거할 가능성이 있나?” → “전방 차량의 속도와 거리, 브레이크 라이트 상태를 고려하면 급정거 확률이 30%이다”와 같은 형태로 중간 결과를 생성함으로써, 최종 궤적 생성 시 보다 풍부한 컨텍스트를 제공한다.

학습 파이프라인은 두 단계로 구성된다. 첫 번째 단계인 감독‑미세조정(Supervised Fine‑Tuning)에서는 기존 주행 데이터셋(NuScenes)에서 제공되는 궤적 라벨을 이용해 VLM이 직접 좌표를 회귀하도록 학습한다. 이때 입력은 카메라 이미지와 함께 “현재 상황에 대한 설명”이라는 텍스트 프롬프트를 결합해 모델이 멀티모달 정보를 활용하도록 설계한다. 두 번째 단계인 궤적 선호 최적화(Trajectory Preference Optimization, TPO)는 강화학습‑유사 방식으로, 여러 후보 궤적 중 인간 운전자가 선호할 만한 궤적을 선택하도록 보상을 설계한다. 구체적으로, 충돌 위험, 법규 위반, 승차감(스무스함) 등을 정량화한 비용 함수를 정의하고, 모델이 생성한 궤적이 이 비용을 최소화하도록 파라미터를 미세조정한다. 이 과정은 “선호 기반 학습(Preference Learning)”이라고도 불리며, 라벨링 비용이 높은 인간 평가 데이터를 효율적으로 활용한다는 장점이 있다.

실험 결과는 NuScenes 테스트 셋에서 평균 ℓ2 오차 0.31 m, 충돌률 0.10%라는 뛰어난 수치를 보여준다. 이는 기존 최첨단 엔드‑투‑엔드 모델(예: BEVFormer, UniAD)보다 15~20% 정도 개선된 결과이며, 특히 충돌률 감소가 눈에 띈다. 충돌률은 안전성 평가에서 가장 중요한 지표 중 하나이므로, LLaViDA가 실제 차량에 적용될 경우 위험 상황을 크게 감소시킬 가능성이 있다. 또한, 모델이 텍스트 기반 추론 과정을 출력하므로 디버깅 및 해석이 용이하다는 부가적인 장점이 있다.

하지만 몇 가지 한계점도 존재한다. 첫째, VLM 자체가 거대한 파라미터 수(수억~수십억)와 높은 연산 비용을 요구하기 때문에 실시간 주행에 적용하려면 경량화 혹은 하드웨어 가속이 필요하다. 둘째, 체인‑오브‑생각 프롬프트 설계가 도메인에 따라 크게 달라질 수 있어, 다른 도시나 국가의 교통 규칙에 맞게 프롬프트를 재조정해야 할 가능성이 있다. 셋째, 현재 실험은 오픈‑루프(open‑loop) 평가에 국한되므로, 폐쇄‑루프(closed‑loop) 시뮬레이션이나 실제 차량 테스트에서의 성능 검증이 추가로 요구된다.

종합하면, LLaViDA는 멀티모달 언어 모델을 궤적 계획에 성공적으로 접목시킨 최초의 사례 중 하나이며, “언어 기반 사고”를 통해 복잡한 교통 상황을 해석하고 안전한 궤적을 생성한다는 점에서 자율주행 연구에 새로운 방향을 제시한다. 향후 경량화, 프롬프트 자동 생성, 실시간 폐쇄‑루프 평가 등을 통해 실용성을 높인다면, 상용 자율주행 시스템에 핵심 모듈로 채택될 가능성이 크다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리