문제 모델링을 통한 안정적인 계획 수립

📝 원문 정보

- Title: Model-First Reasoning LLM Agents: Reducing Hallucinations through Explicit Problem Modeling

- ArXiv ID: 2512.14474

- 발행일: 2025-12-16

- 저자: Annu Rana, Gaurav Kumar

📝 초록 (Abstract)

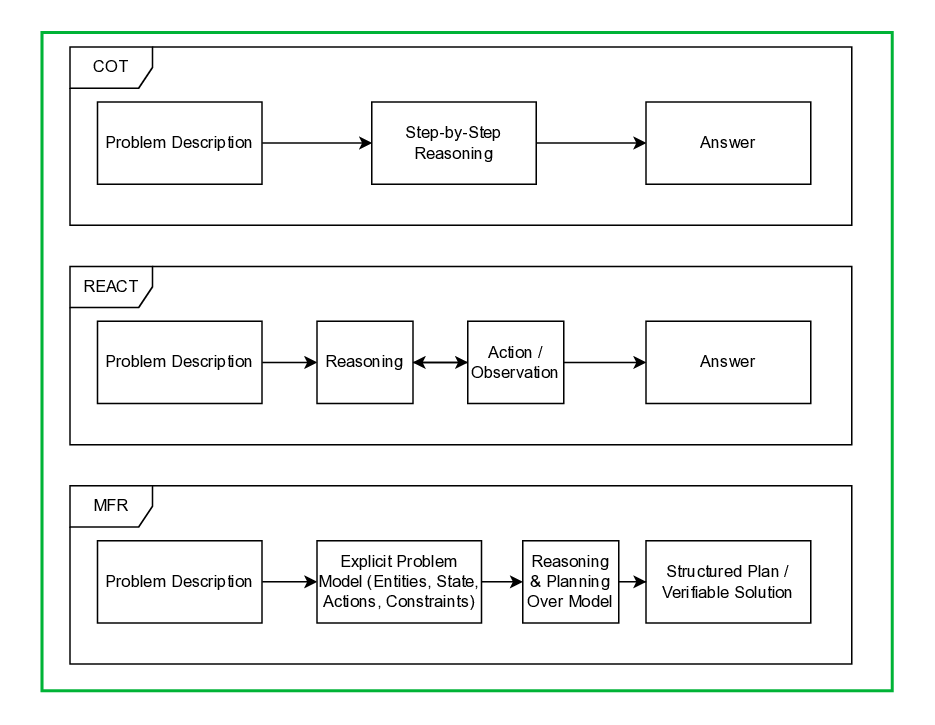

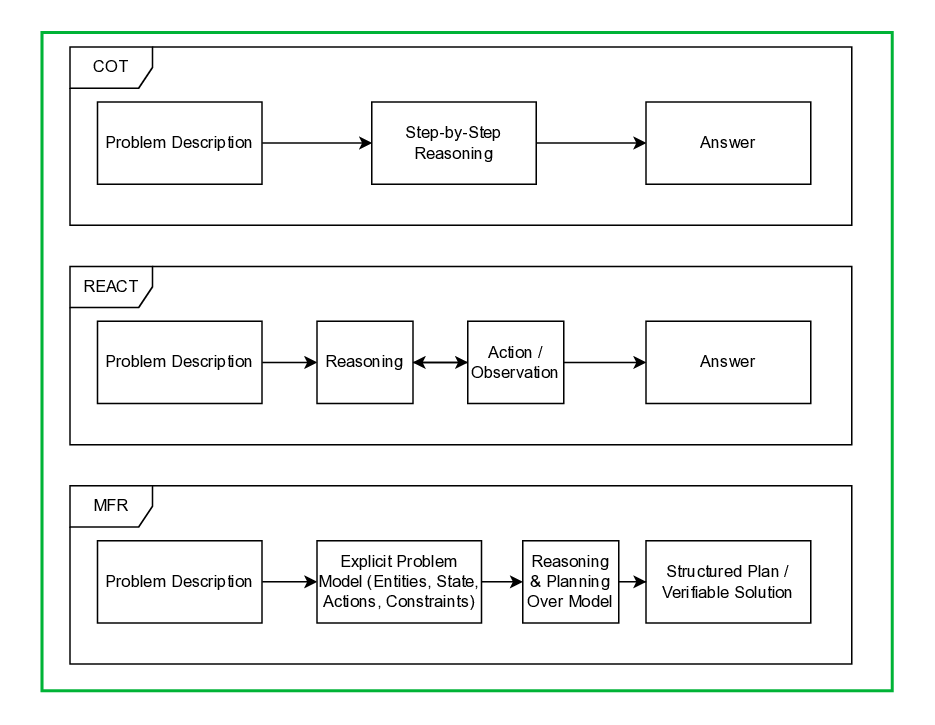

대형 언어 모델(LLMs)은 체인-오브-사상(CoT) 및 ReAct와 같은 프롬프팅 전략의 가이드로 인해 추론과 계획에서 놀라운 능력을 보여주고 있습니다. 그러나 이러한 발전에도 불구하고, LLM 기반 에이전트는 여전히 복잡한 다단계 계획 작업에서 실패하며, 제약 위반, 일관성 없는 상태 추적 및 미세한 변화에 취약한 솔루션을 생성하는 경향이 있습니다. 우리는 이러한 많은 실패들이 추론의 결함 때문이 아니라 명시적인 문제 표현의 부재 때문이라고 주장합니다. 인간의 과학적 추론, 고전 AI 계획, 그리고 의사결정 인지 모델과는 달리 현재 LLM 프롬프팅 패러다임은 추론을 암묵적이고 불안정한 내부 작업 모델 위에서 진행됩니다. 이러한 전통에 영감을 받아 우리는 Model-First Reasoning(MFR)을 제안합니다. MFR은 두 단계를 거치는 패러다임으로, LLM이 먼저 문제의 구조화된 모델을 명시적으로 구성하는 단계와 그 모델에 대한 추론 및 계획 단계로 나뉩니다. 다양한 제약 조건 중심 계획 도메인에서 실험을 통해 MFR은 제약 위반을 크게 줄이고, 장기 일관성을 향상시키며, CoT 또는 ReAct를 사용하여 생성된 것보다 더 해석 가능하고 검증 가능한 솔루션을 제공한다는 것을 보여줍니다. 추출 연구는 모델링과 추론을 분리하는 것이 이러한 성능 향상에 중요하다는 것을 확인합니다. 우리는 많은 관찰된 LLM 계획 실패가 근본적으로 표현적 문제이며, 명시적인 문제 모델링이 신뢰할 수 있는 에이전트 AI 시스템의 기본 구성 요소로 간주되어야 한다고 결론지었습니다.💡 논문 핵심 해설 (Deep Analysis)

실험 결과 MFR은 다양한 제약 조건 중심 계획 도메인에서 제약 위반을 크게 줄이고, 장기 일관성을 향상시키며, 해석 가능하고 검증 가능한 솔루션을 제공하는 것으로 나타났습니다. 추출 연구를 통해 모델링과 추론을 분리하는 것이 이러한 성능 향상에 중요한 역할을 한다는 것을 확인하였습니다.

이 논문은 LLM 기반 에이전트의 계획 실패가 근본적으로 표현적 문제이며, 명시적인 문제 모델링이 신뢰할 수 있는 AI 시스템 구축에서 핵심 요소임을 강조합니다. 이러한 접근법은 복잡한 작업에서 LLMs의 성능을 크게 향상시키고, 그 결과를 더 안정적이고 일관성 있게 만드는 데 기여할 수 있습니다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리

Reference

이 글은 ArXiv의 공개 자료를 바탕으로 AI가 자동 번역 및 요약한 내용입니다.

저작권은 원저자에게 있으며, 인류 지식 발전에 기여한 연구자분들께 감사드립니다.