뇌파로부터 제스처를 재구성하는 새로운 딥러닝 프레임워크

📝 원문 정보

- Title: fMRI2GES: Co-speech Gesture Reconstruction from fMRI Signal with Dual Brain Decoding Alignment

- ArXiv ID: 2512.01189

- 발행일: 2025-12-01

- 저자: Chunzheng Zhu, Jialin Shao, Jianxin Lin, Yijun Wang, Jing Wang, Jinhui Tang, Kenli Li

📝 초록 (Abstract)

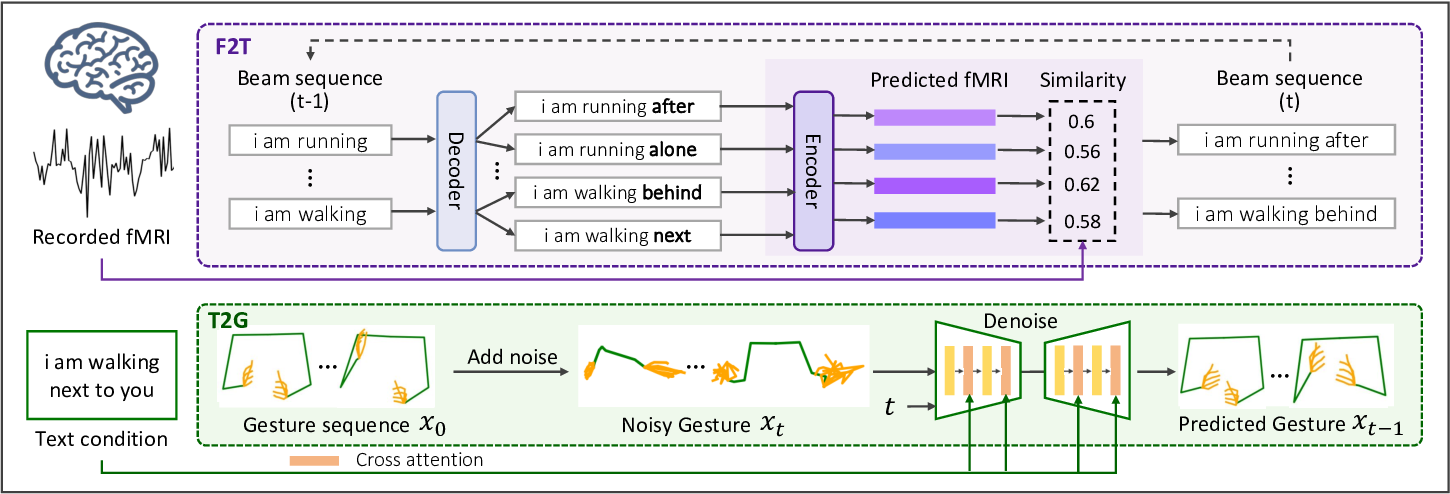

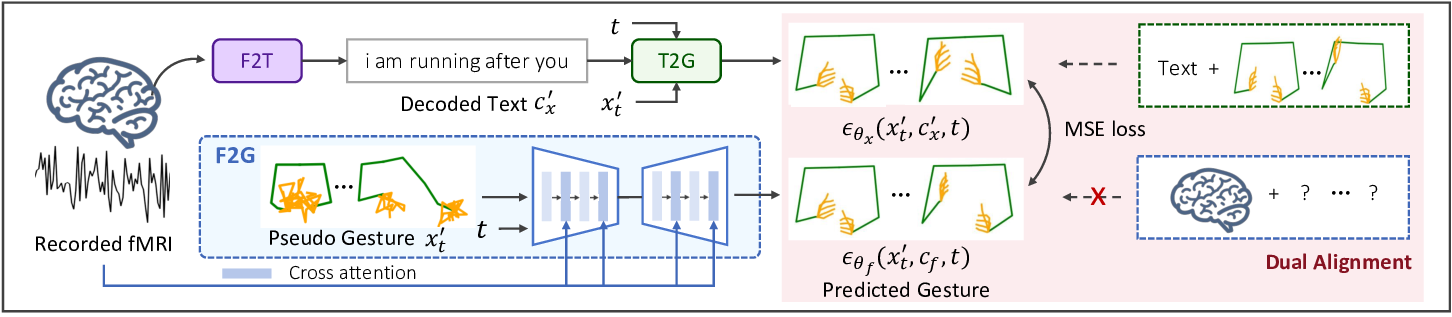

뇌가 외부 자극에 어떻게 반응하고 이를 어떻게 해독할 수 있는지는 신경과학에서 오랫동안 해결되지 않은 과제이다. 기존 연구들은 주로 뇌‑이미지 혹은 뇌‑언어 재구성에 초점을 맞추었지만, 본 연구는 뇌가 인식한 말소리와 연관된 제스처를 재구성하는 것을 목표로 한다. 그러나 {뇌, 언어, 제스처}가 동시에 매칭된 데이터가 부족해 딥러닝 모델을 직접 학습시키기 어렵다. 이를 해결하기 위해 우리는 Dual Brain Decoding Alignment를 이용해 비연계 데이터에서도 fMRI‑to‑gesture 재구성 네트워크를 학습할 수 있는 새로운 접근법 fMRI2GES를 제안한다. 이 방법은 (i) 뇌 반응을 유발하는 관찰된 텍스트와 (ii) 제스처에 대한 텍스트 설명이라는 두 가지 정보를 활용한다. 완전한 지도 학습이 아니라, fMRI‑to‑text 모델, 텍스트‑to‑gesture 모델(쌍(pair) 데이터 사용) 및 fMRI‑to‑gesture 모델(비연계 데이터 사용)을 결합해 두 개의 fMRI‑to‑gesture 재구성 경로를 만든 뒤, 두 출력값을 명시적으로 정렬하고 자체 지도(self‑supervision) 방식으로 모델을 훈련한다. 실험 결과, 제안된 방법이 fMRI 기록만으로도 표현력 있는 제스처를 직접 재구성할 수 있음을 보였다. 또한 피질의 다양한 ROI에서 얻은 fMRI 신호가 생성 결과에 미치는 영향을 조사하였다. 전반적으로 우리는 공동 말소리 제스처 디코딩에 새로운 통찰을 제공함으로써 신경과학 및 인지과학 연구에 기여한다.💡 논문 핵심 해설 (Deep Analysis)

두 고리를 결합하면, fMRI 입력이 텍스트를 거쳐 제스처로 변환되는 ‘두 개의 경로’를 얻게 된다. 첫 번째 경로는 fMRI‑to‑gesture 직접 매핑 모델이며, 두 번째 경로는 fMRI‑to‑text → text‑to‑gesture 순차 변환이다. 저자들은 이 두 경로가 생성하는 제스처 시퀀스가 서로 일치하도록 ‘Dual Brain Decoding Alignment’를 적용한다. 구체적으로는 두 출력 사이의 차이를 최소화하는 손실 함수를 정의하고, 이를 통해 fMRI‑to‑gesture 모델을 자체 지도(self‑supervision) 방식으로 미세 조정한다. 이렇게 하면 비연계 데이터만으로도 fMRI‑to‑gesture 매핑을 효과적으로 학습할 수 있다.

또한 논문은 피질의 다양한 영역(ROI)이 제스처 재구성에 미치는 영향을 실험적으로 검증한다. 예를 들어, 전두엽, 측두엽, 운동피질 등 각각의 ROI에서 추출한 fMRI 신호를 별도로 입력했을 때 생성되는 제스처의 풍부함과 정확도가 어떻게 달라지는지를 분석한다. 결과는 운동 관련 영역이 제스처의 동작 형태를 더 정확히 재현하는 반면, 언어 처리 영역은 제스처의 의미적 연관성을 강화한다는 점을 시사한다.

이 연구가 갖는 의미는 두 가지로 요약될 수 있다. 첫째, ‘비연계 데이터’를 활용한 교차 모달리티 정렬 기법은 뇌‑컴퓨터 인터페이스(BCI) 분야에서 데이터 부족 문제를 해결할 새로운 패러다임을 제시한다. 둘째, 제스처라는 복합적인 비언어적 신호를 뇌 활동으로부터 직접 복원함으로써, 인간의 의사소통 메커니즘을 다차원적으로 이해할 수 있는 기반을 마련한다. 다만 현재 모델은 제스처의 세밀한 동작(예: 손가락 관절 각도)까지는 재현하지 못하고, 텍스트‑to‑gesture 변환 단계에서 사용된 데이터의 품질에 크게 의존한다는 한계가 있다. 향후 연구에서는 고해상도 모션 캡처 데이터와 더 정교한 시퀀스‑투‑시퀀스 모델을 결합해 정밀도와 일반화를 동시에 높이는 방향이 기대된다.

📄 논문 본문 발췌 (Excerpt)

📸 추가 이미지 갤러리